【协和医学杂志】医学影像跨模态重建中的生成对抗网络研究进展

2024-01-21 协和医学杂志 协和医学杂志 发表于陕西省

多模态医学影像是采用不同的医学成像技术[包括X线、CT、MRI、正电子发射断层显像(PET)等]获取影像学数据,临床医生可通过综合分析不同的影像信息明确患者的诊断。

多模态医学影像是采用不同的医学成像技术[包括X线、CT、MRI、正电子发射断层显像(PET)等]获取影像学数据,临床医生可通过综合分析不同的影像信息明确患者的诊断[1]。例如,肿瘤科医生可通过CT、MRI和PET/CT等评估肿瘤的部位、大小、形态、浸润深度及其与周围组织的关系。

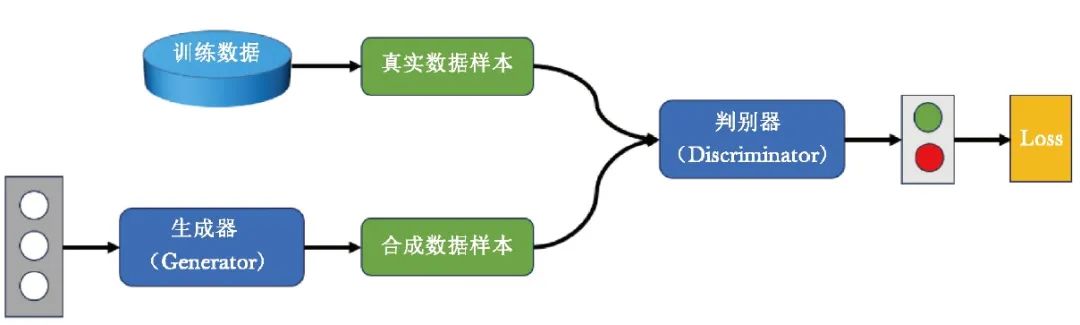

然而,由于存在医疗设备资源短缺及诊疗时间受限等问题,医生一般无法在短时间内获得所需的多模态影像信息[2]。而跨模态医学影像重建技术能够生成临床所需的多模态医学影像,辅助医生对疾病进行精准诊疗,具体流程见图1。

图1 跨模态医学影像重建流程图

其中,传统跨模态医学影像重建技术主要包括基于图集、稀疏编码和传统机器学习的方法,但其耗时、耗力、稳定性及通用性较差[3-7]。近年来,自编码器(AE)[8]、卷积神经网络(CNN)[9-10]及生成对抗网络(GAN)[11]等新技术陆续产生。其中, AE在编码-解码的过程中可能造成信息丢失,导致重建影像质量较差,CNN对图像中的噪声和伪影较为敏感,影响重建的准确性和稳定性。

而GAN可重建出临床所需的高质量多模态医学影像,最大程度地节约医疗设备资源并加快就诊速度。本文就GAN在X线、CT、MRI、PET等多模态影像之间的跨模态重建应用研究作一综述,以期为开发更先进的跨模态重建技术提供借鉴。

1 GAN模型

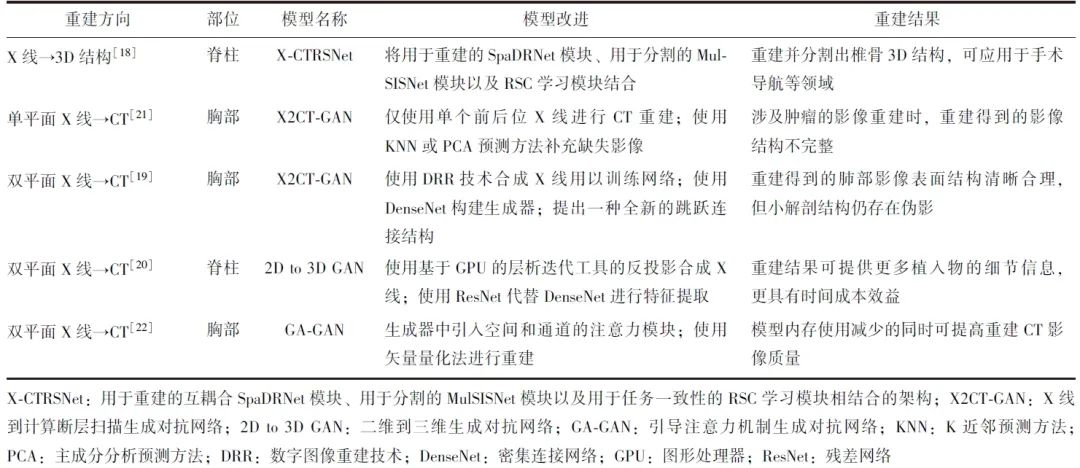

GAN模型是一种生成模型,由Goodfellow等[11]于2014年首次提出,引起了学术界和工业界的广泛关注。GAN包含生成器和判别器2个基础网络,见图2。

图2 生成对抗网络示意图

其中,生成器(下文简称“G”)的目标是生成与真实数据类似的假数据,判别器(下文简称“D”)的目标则是最大程度地区分真实数据和假数据[12]。

GAN采用对抗训练策略,即当G生成的假数据越来越真时,D为保持准确性,必须向判别能力越来越强的方向迭代;当D越来越强大时,G为了降低D的准确性,必须生成越来越真的数据。两者在博弈过程中不断迭代,共同进化[13]。

现有GAN模型通过学习源模态至目标模态的全局样本空间映射,已被广泛用于跨模态医学影像重建[14]。由于采用对抗训练策略,GAN对影像的细节具有更好的生成性能[15]。与其他生成模型相比,GAN具有从训练数据中学习原始数据分布和生成高分辨率图像的能力[16]。

近年来,随着计算能力的提升及大规模数据集可用性的提高,GAN在理论与模型应用方面得以飞速发展,并被广泛用于医疗领域,协助医生进行术前规划、术中植入物位置评估和术后评估。

2 GAN在X线与CT之间的跨模态重建应用

目前,GAN在X线与CT之间的跨模态重建应用研究主要基于X线影像重建生成CT影像或还原出器官的3D结构,并用于手术导航等领域[17-18]。

Ying等[19]提出X2CT-GAN网络,将双平面X线影像重建生成CT影像,并在公开的胸部CT数据集上验证其有效性,通过使用数字图像重建技术(DRR)生成模拟X线,用以训练网络,重建生成的肺部CT影像表面结构清晰合理,但小解剖结构仍存在伪影。

Yang等[20]对X2CT-GAN网络加以改进,提出2D to 3D GAN网络,结合放射科医生的经验调整输入信号,使用不同骨骼信号、不同大小的脊柱数据集比较重建效果,采用ResNet代替DenseNet进行特征提取,需要的显存更小,训练时间更短。使用基于图形处理器(GPU)的层析迭代工具(TIGRE)的反投影合成X线训练网络,可提供更多植入物细节信息,提示GAN在脊柱2D/3D影像配准方面具有临床应用潜力。

双平面(前后位和侧位)X线中包含互补信息,二者结合更有利于CT重建,但在特殊情况下双平面影像获取受限,只有单平面X线影像可用。

Schock等[21]在X2CT-GAN的基础上,仅使用单个前后位X线影像进行CT重建,但涉及肿瘤影像时,重建的影像结构不完整。

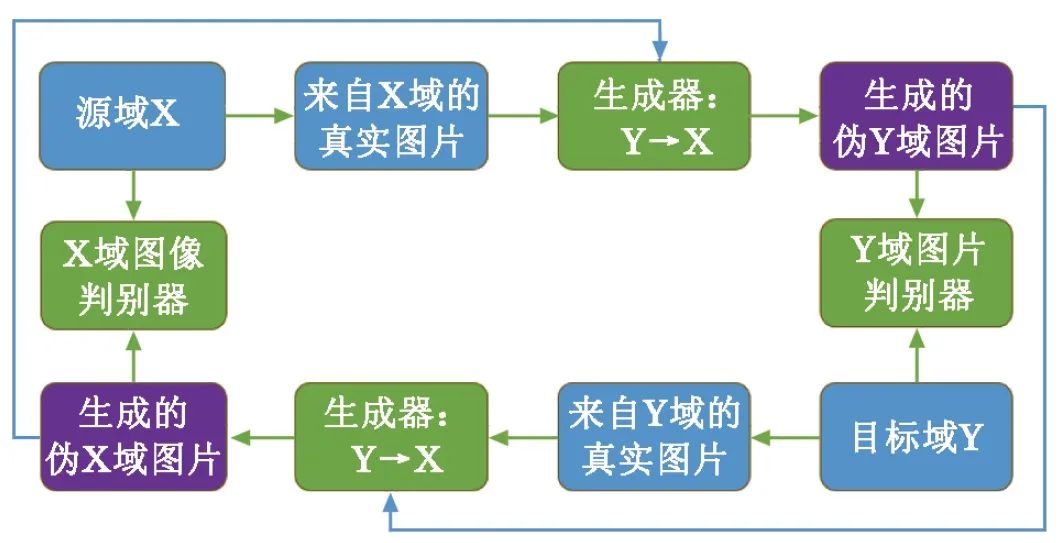

医学影像中的结构和组织存在广泛的空间关联,关键信息可能分布在不同区域,Sinha等[22]提出基于引导注意力机制的生成对抗网络(GA-GAN),在生成器中引入空间和通道的注意力模块以提高重建的CT影像质量,可根据不同尺度的特征重要性进行加权,更好地处理医学影像尺度变化(表1)。

表1 X射线与CT之间的跨模态重建模型

使用GAN实现X线影像到CT影像的跨模态重建具有临床应用前景,重建得到的CT影像可辅助医生判断空间结构,可应用于髋关节假体置换术的规划、测量器官(如肺、心脏)大小、检测器官位置以及制订放疗计划。目前,GAN模型虽可成功重建出高质量医学影像,但在处理细微结构和纹理方面仍有所欠缺,在处理细节时常出现模糊、不真实或缺失的情况。

3 GAN在CT与MRI之间的跨模态重建应用

基于CT影像重建MRI影像,可解决特殊患者MRI检查的难题,如接受人工关节置换的患者、心脏起搏器患者[23]。Jiang等[24]设计一种肿瘤感知的无监督跨域适应方法,引入针对肿瘤的特异性感知损失,可更好地保留肿瘤信息。Jin等[25]结合双循环一致损失和体素损失提出MR-GAN网络,可实现将脑CT影像重建生成脑MRI影像。

基于MRI影像重建CT影像,已广泛用于制定癌症放疗计划,可获得与实际CT影像相似的组织密度信息,更准确地计算辐射剂量。Maspero等[26]使用骨盆MRI影像训练pix2pix网络重建CT影像,有助于前列腺癌患者的剂量计算。王蕾等[27]结合GAN模型和U-Net模型建立鼻咽癌MRI影像与CT影像的映射模型,在MRI影像引导的放疗过程中重建CT影像。Abu-Srhan等[28]提出无监督注意力引导生成对抗网络(UagGAN),实现了MRI影像与CT影像之间的双向转换,可应用于辅助诊断、手术规划和导航等方面。

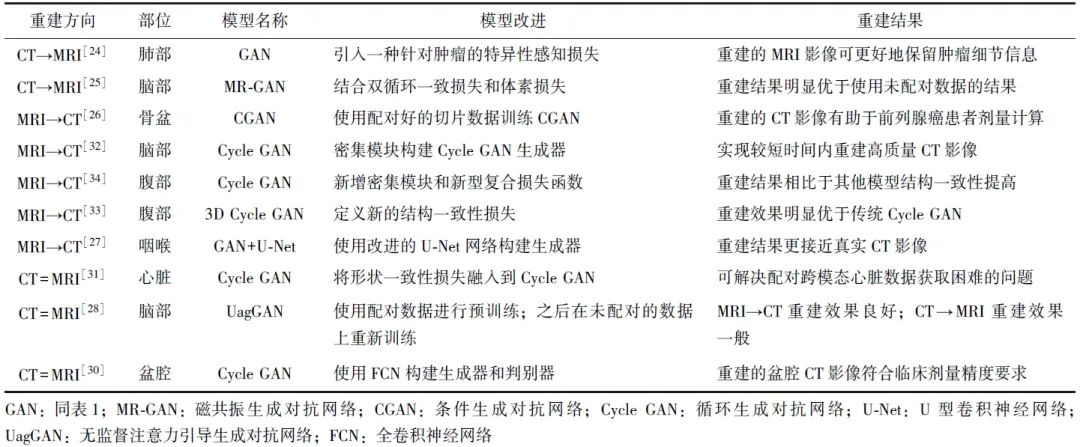

不同模态影像之间的配对结果影响重建影像的生成质量,且获取配对准确的CT影像和MRI影像较为困难。为此,循环生成对抗网络(Cycle GAN)被提出,如图3所示,Cycle GAN可学习源影像与目标影像之间的映射关系,影像配对结果不影响其训练过程,实现未配对的不同模态影像间的相互转换[29]。

图3 循环生成对抗网络示意图

吴香奕等[30]利用Cycle GAN实现盆腔部位的未配对MRI影像与CT影像之间的相互转换,重建得到的盆腔CT影像符合临床剂量精度要求。Cycle GAN技术可在脑、心脏和盆腔等部位实现不同模态影像之间的转换,为医学影像研究及医疗实践提供了新思路。

但Cycle GAN也会生成一些不可靠的结果,导致误诊。为此,研究者对Cycle GAN进行了诸多改进,Zhang等[31]将形状一致性损失融入到Cycle GAN中,实现了心血管CT影像和MRI影像之间的相互转换,解决了配对跨模态心脏数据获取难题。Lei等[32]使用密集模块构建Cycle GAN生成器,可在较短时间内重建高质量CT影像,为后续实时MRI治疗提供了依据。Yang等[33]提出一种无监督MRI-CT合成的结构约束Cycle GAN,可应用于未配对的脑腹部MRI-CT影像重建。Liu等[34]基于3D Cycle GAN架构,新增密集模块和新型复合损失函数,使用腹部MRI影像重建CT影像。Wang等[35]将改进的可变形卷积块集成到网络架构中,并提出新型周期一致性损失和图像对齐损失,在多序列脑部MRI数据和多模态腹部MRI数据中证明了该方法的有效性,解决了源数据与目标数据对齐的难题。

使用Cycle GAN实现CT影像与MRI影像的跨模态重建,重建出的影像伪影较少且分辨率较高,但Cycle GAN网络的重建结果受训练数据的配对程度影响(表2)。此外,上述方法难以重建复杂病变区域,易忽略病灶的定位、结构等细节信息,进而影响病变区域的重建效果。

表2 CT与MRI之间的跨模态重建模型

4 GAN在MRI与PET之间的跨模态重建应用

跨模态重建MRI影像和PET影像可提供互补的疾病信息[36],用于诊断阿尔茨海默症(AD)等脑部疾病[37]。然而,由于PET费用较高且放射性药物使用许可受到限制,其临床应用受限。基于MRI影像重建的PET影像可协助医生诊断疾病。

Hu等[38]提出用双向映射生成对抗网络(BMGAN)重建PET影像,并在AD数据集中验证了该方法的有效性,结合重建的PET影像和MRI影像进行AD分类。

Pan等[39]基于Cycle GAN提出了AD诊断和轻度认知损伤(MCI)预测模型。Gao等[40]提出任务导向的金字塔和注意力生成对抗网络(TPA-GAN),基于给定配对的MRI影像重建PET影像。

PET影像还可用于定位癫痫致癫区,Yaakub等[41]提出3DGAN模型,重建得到的PET影像可作为辅助医生诊断的客观补充。Wei等[42]提出定义特定损失函数的生成对抗网络(sketcher-refiner GAN),从MRI重建PET衍生的髓鞘含量图预测病变区域的脱髓鞘含量。

PET影像的清晰度较MRI更低,但也有研究从PET影像重建MRI影像。如Choi等[43]优化pix2pix网络,从淀粉样蛋白(Aβ)的PET影像成功重建MRI影像,可用于精确的Aβ定量分析,但重建MRI影像在视觉上很难区分灰质和白质,且具有一定的伪影(表3)。后续研究人员对GAN模型作出不同改进,使重建MRI影像显示的诊断信息更加丰富[44-45]。

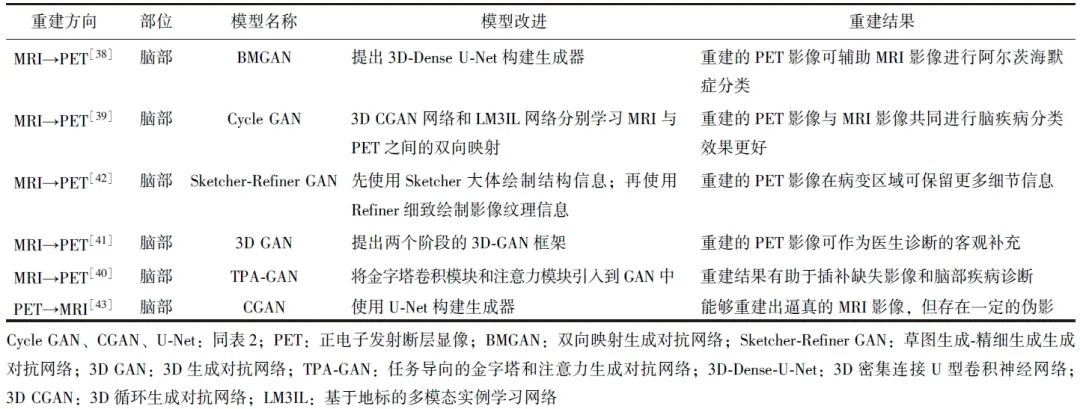

表3 MRI与PET之间的跨模态重建模型

使用GAN模型实现MRI影像和PET影像的跨模态重建可提供多模态影像信息并补充缺失的病理信息,但仍存在数据不匹配的问题,如何准确地将两种模态的数据对齐,以保持特征的一致性和准确性,是未来改进的方向。

5 GAN在CT与PET之间的跨模态重建应用

基于CT影像重建PET影像,可实现仅有CT影像的情况下进行病变检测,减少对患者的辐射。Ben-Cohen等[46]将全卷积神经网络(FCN)与条件生成对抗网络(CGAN)相结合,从CT影像重建PET影像,更易识别恶性肝脏病变区域,无需在训练前手动标记病变区域。

基于PET 影像重建CT影像,可应用于PET数据的衰减校正。Dong等[59]对Cycle GAN进行改进,以自注意力U-Net构建生成器,重建得到的CT影像与真实CT影像相似且在软组织上显示出良好的对比度。

Armanious等[48]提出专门用于医学影像转换的生成对抗网络(MedGAN)架构,连接多个FCN构建生成器,确保重建出高分辨率清晰的CT影像。

Upadhyay等[49]提出渐进式生成对抗网络(UP-GAN),通过级联MedGAN模型,以渐进方式训练GAN的注意力图,逐渐生成保真度增加的CT影像(表4)。

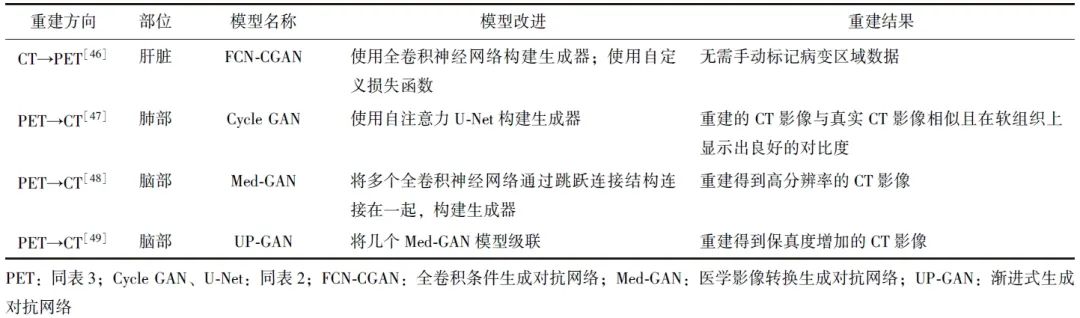

表4 CT与PET之间的跨模态重建模型

使用GAN实现PET影像与CT影像的跨模态重建有助于识别病变以及PET数据的衰减校正,但仍存在以下不足:PET影像包含较多的噪声,而CT影像较为清晰,但噪声预处理问题需要解决;PET影像和CT影像的分辨率和对比度不同,如要解决解剖结构和医学特征的对应问题,需更高级的图像配准和分割算法。

6 GAN在多种模态影像之间的跨模态重建应用

现有的GAN模型变体是通过学习从源模态到目标模态的全局样本空间映射,并将该映射应用于整个空间中的所有样本进行预测。但医学数据集稀缺且获取存在难度,在数量有限的数据集上学习出适用于所有医学影像的跨模态重建模型存在一定的挑战性。

目前,已有研究提出可应用于重建多种模态医学影像的模型,例如,Tomar等[50]提出一种基于GAN网络的自适应医学影像重建方法,在多模态心脏和脑肿瘤数据集上验证了该方法的有效性;Chen等[51]提出新型目标感知生成对抗网络(Tar-GAN),其是一种通用的多种模态医学影像转换模型,能够在不依赖配对数据的情况下实现多种模态转换;Yu等[52]提出样本自适应生成对抗网络(SA-GAN),其不仅学习从源模态到目标模态的全局样本空间映射,还学习每个样本独有的特征,新增的样本适应路径使SA-GAN网络可根据不同样本进行自我调整,大幅提升了重建模型性能,此外,SA-GAN中提及的样本自适应策略可改进各种GAN网络,并根据实际需求进行调整。

7 小结与展望

高质量多模态医学影像是实现临床疾病诊疗的关键组成部分,在相同的生理状态下,对同一病灶进行多种模态的影像重建,充分利用不同模态的互补作用,可辅助医生快速作出诊断决策,并用于术前方案制定、智能医疗和医学大数据分析等研究领域。

GAN在不同场景下的医学影像跨模态重建应用已取得一定成果,但仍存在如下不足:(1)泛化程度受限:单一模型实现多种模态之间的重建尚有难度,且现有的重建方法通常在特定数据集上训练,难以在不同数据集或不同场景中泛化,跨域泛化成为限制跨模态重建结果的一个关键挑战。(2)重建准确性不足:不同模态医学影像各自携带了不同的信息,在跨模态重建中,由于部分信息缺失,可能无法完全捕捉到两种模态的细微变化和相关特征,从而影响重建结果的准确性和完整性。(3)评估指标不准确:缺乏一致的评估指标和标准。如何客观、准确地评估跨模态重建结果的质量和可行性亟待解决。(4)算法过于复杂:现有的跨模态重建方法涉及复杂的网络架构、多阶段的训练过程或迭代优化,导致计算复杂度较高,耗时较长,限制其在临床应用中的效率和实时性。(5)算法可解释性不足:多模态算法不仅需重建出高质量的影像,还应提供可解释的医学信息,以便医生作出准确的诊断。

未来应着眼于建立更强大、更通用、更轻量化的网络模型,以现有模型为基础,开发更先进的跨模态重建技术,以期在医学影像领域发挥更重要的作用,为医生提供更加准确和全面的诊断信息。

参考文献

[1]Yu B, Wang Y, Wang L, et al. Medical image synthesis via deep learning[J]. Adv Exp Med Biol, 2020, 1213: 23-44.

[2]Luo Y, Nie D, Zhan B, et al. Edge-preserving MRI image synthesis via adversarial network with iterative multi-scale fusion[J]. Neurocomputing, 2021, 452: 63-77.

[3]Avants BB, Epstein CL, Grossman M, et al. Symmetric diffeomorphic image registration with cross-correlation: evaluat-ing automated labeling of elderly and neurodegenerative brain[J]. Med Image Anal, 2008, 12: 26-41.

[4]Roy S, Carass A, Shiee N, et al. MR contrast synthesis for lesion segmentation[C]. Proc IEEE Int Symp Biomed Imaging, 2010,2010: 932-935.

[5]Ye DH, Zikic D, Glocker B, et al. Modality propagation: coherent synthesis of subject-specific scans with data-driven regularization[C]. Med Image Comput Comput Assist Interv, 2013, 16: 606-613.

[6]Huynh T, Gao Y, Kang J, et al. Estimating CT image from MRI data using structured random forest and auto-context model[J]. IEEE Trans Med Imaging, 2016, 35: 174-183.

[7]Jog A, Carass A, Roy S, et al. Random forest regression for magnetic resonance image synthesis[J]. Med Image Anal, 2017, 35: 475-488.

[8]Jiang J, Veeraraghavan H. Unified cross-modality feature disentangler for unsupervised multi-domain MRI abdomen organs segmentation[C]. Med Image Comput Comput Assist Interv, 2020,12262: 347-358.

[9]Xiong Z, Stiles MK, Yao Y, et al. Automatic 3D surface reconstruction of the left atrium from clinically mapped point clouds using convolutional neural networks[J]. Front Physiol, 2022, 13: 880260.

[10]Shen L, Zhao W, Xing L. Patient-specific reconstruction of volumetric computed tomography images from a single projection view via deep learning[J]. Nat Biomed Eng, 2019, 3: 880-888.

[11]Goodfellow I, Pouget-Abadie J, Mirza M, et al. Generative adversarial nets[J]. Adv Neural Inf Process Syst, 2014, 27:2672-2680.

[12]Aggarwal A, Mittal M, Battineni G. Generative adversarial network: An overview of theory and applications[J]. Int J Inf Manage, 2021, 1: 100004.

[13]Wang K, Gou C, Duan Y, et al. Generative adversarial networks: introduction and outlook[J]. IEEE/CAA J Autom Sin, 2017, 4: 588-598.

[14]Singh NK, Raza K. Medical image generation using generative adversarial networks: A review[J]. Health Informatics J, 2021: 77-96.

[15]Zhou J. Research on Generative Adversarial Networks and Their Applications in Image Generation[C]. IEEE Int Conf Adv Electr Eng Comput Appl, 2022: 1144-1147.

[16]Ravi D, Blumberg SB, Ingala S, et al. Degenerative adversarial neuroimage nets for brain scan simulations: Applica-tion in ageing and dementia[J]. Med Image Anal, 2022, 75: 102257.

[17]Jecklin S, Jancik C, Farshad M, et al. X23D-Intraopera-tive 3D Lumbar Spine Shape Reconstruction Based on Sparse Multi-View X-ray Data[J]. J Imaging, 2022, 8: 271.

[18]Ge R, He Y, Xia C, et al. X-CTRSNet: 3D cervical vertebra CT reconstruction and segmentation directly from 2D X-ray images[J]. Knowl Based Syst, 2022, 236: 107680.

[19]Ying X, Guo H, Ma K, et al. X2CT-GAN: reconstructing CT from biplanar X-rays with generative adversarial networks[C]. Proc IEEE Comput Soc Vision Pattern Recognit, 2019: 10619-10628.

[20]Yang CJ, Lin CL, Wang CK, et al. Generative Adversarial Network (GAN) for Automatic Reconstruction of the 3D Spine Structure by Using Simulated Bi-Planar X-ray Images[J]. Diagnostics, 2022, 12: 1121.

[21]Schock J, Lan YC, Truhn D, et al. Monoplanar CT Reconstruction with GANs[C]. IPTA, 2022: 1-6.

[22]Sinha A, Sugawara Y, Hirano Y. GA-GAN: CT reconstruction from biplanar DRRs using GAN with guided attention[J]. CORR, 2019.doi:10.48550/arXiv.1909.12525.

[23]Zhan B, Xiao J, Cao C, et al. Multi-constraint generative adversarial network for dose prediction in radiotherapy[J]. Med Image Anal, 2022, 77: 102339.

[24]Jiang J, Hu YC, Tyagi N, et al. Tumor-aware, adversarial domain adaptation from CT to MRI for lung cancer segmentation[C]. Med Image Comput Comput Assist Interv, 2018: 777-785.

[25]Jin CB, Kim H, Liu M, et al. Deep CT to MR synthesis using paired and unpaired data[J]. Sensors, 2019, 19: 2361.

[26]Maspero M, Savenije MHF, Dinkla AM, et al. Dose evaluation of fast synthetic-CT generation using a generative adversarial network for general pelvis MR-only radiotherapy[J]. Phys Med Biol, 2018, 63: 185001.

[27]王蕾, 李媛茜. 基于生成对抗网络的CT图像生成[J]. 成都信息工程大学学报, 2021, 36: 286-292.

[28]Abu-Srhan A, Almallahi I, Abushariah MAM, et al. Paired-unpaired Unsupervised Attention Guided GAN with transfer learning for bidirectional brain MR-CT synthesis[J]. Comput Biol Med, 2021, 136: 104763.

[29]Zhu JY, Park T, Isola P, et al. Unpaired image-to-image translation using cycle-consistent adversarial networks[C]. Proc IEEE Comput Soc Vision Pattern Recognit, 2017: 2223-2232.

[30]吴香奕, 曹锋, 曹瑞芬, 等. 基于循环一致性生成对抗网络的盆腔伪CT生成方法[J]. 中国医学物理学杂志, 2021, 38: 21-29.

[31]Zhang Z, Yang L, Zheng Y. Translating and segmenting multimodal medical volumes with cycle-and shape-consistency generative adversarial network[C]. Proc IEEE Comput Soc Vision Pattern Recognit, 2018: 9242-9251.

[32]Lei Y, Harms J, Wang T, et al. MRI-only based synthetic CT generation using dense cycle consistent generative adversarial networks[J]. Med Phys, 2019, 46: 3565-3581.

[33]Yang H, Sun J, Carass A, et al. Unsupervised MR-to-CT synthesis using structure-constrained Cycle GAN[J]. IEEE Trans Med Imaging, 2020, 39: 4249-4261

[34]Liu Y, Lei Y, Wang T, et al. Liver synthetic CT generation based on a dense-Cycle GAN for MRI-only treatment planning[C]. Image Processing, 2020, 11313: 659-664.

[35]Wang C, Yang G, Papanastasiou G, et al. DiCyc: GAN-based deformation invariant cross-domain information fusion for medical image synthesis[J]. Inf Fusion, 2021, 67: 147-160.

[36]Wang R, Bashyam V, Yang Z, et al. Applications of generative adversarial networks in neuroimaging and clinical neuroscience[J]. Neuroimage, 2023,269: 119898.

[37]Zhang J, He X, Qing L, et al. BPGAN: Brain PET synthesis from MRI using generative adversarial network for multi-modal Alzheimer's disease diagnosis[J]. Comput Meth Prog Bio, 2022, 217: 106676.

[38]Hu S, Lei B, Wang S, et al. Bidirectional mapping generative adversarial networks for brain MR to PET synthesis[J]. IEEE Trans Med Imaging, 2021, 4: 145-157.

[39]Pan Y, Liu M, Lian C, et al. Synthesizing missing PET from MRI with cycle-consistent generative adversarial networks for Alzheimer's disease diagnosis[C]. Med Image Comput Comput Assist Interv, 2018: 455-463.

[40]Gao X, Shi F, Shen D, et al. Task-induced pyramid and attention GAN for multimodal brain image imputation and classification in alzheimer's disease[J]. IEEE J Biomed Health Inf, 2021, 26: 36-43.

[41]Yaakub SN, McGinnity CJ, Clough JR, et al. Pseudo-normal PET synthesis with generative adversarial networks for localising hypometabolism in epilepsies[C]. SASHIMI, 2019: 42-51.

[42]Wei W, Poirion E, Bodini B, et al. Learning myelin content in multiple sclerosis from multimodal MRI through adver-sarial training[C]. Med Image Comput Comput Assist Interv, 2018: 514-522.

[43]Choi H, Lee DS. Generation of structural MR images from amyloid PET: application to MR-less quantification[J]. J Nucl Med, 2018, 59: 1111-1117.

[44]Zhan B, Li D, Wang Y, et al. LR-CGAN: Latent representation based conditional generative adversarial network for multi-modality MRI synthesis[J]. Biomed Signal Process Control, 2021, 66: 102457.

[45]Zhan B, Zhou L, Li Z, et al. D2FE-GAN: Decoupled dual feature extraction based GAN for MRI image synthesis[J]. Knowl Based Sys, 2022, 252: 109362.

[46]Ben-Cohen A, Klang E, Raskin SP, et al. Cross-modality synthesis from CT to PET using FCN and GAN networks for improved automated lesion detection[J]. Eng Appl Artif Intell, 2019, 78: 186-194.

[47]Dong X, Wang T, Lei Y, et al. Synthetic CT generation from non-attenuation corrected PET images for whole-body PET imaging[J]. Phys Med Biol, 2019, 64: 215016.

[48]Armanious K, Jiang C, Fischer M, et al. MedGAN: Medical image translation using GANs[J]. Comput Med Imag Grap, 2020, 79: 101684.

[49]Upadhyay U, Chen Y, Hepp T, et al. Uncertainty-guided progressive GANs for medical image translation[C]. Med Image Comput Comput Assist Interv, 2021: 614-624.

[50]Tomar D, Lortkipanidze M, Vray G, et al. Self-attentive spatial adaptive normalization for cross-modality domain adaptation[J]. IEEE Trans Med Imaging, 2021, 40: 2926-2938.

[51]Chen J, Wei J, Li R. TarGAN: target-aware generative adversarial networks for multi-modality medical image translation[C]. Med Image Comput Comput Assist Interv, 2021: 24-33.

[52]Yu B, Zhou L, Wang L, et al. Sample-adaptive GANs: linking global and local mappings for cross-modality MR image synthesis[J]. IEEE Trans Med Imaging, 2020, 39: 2339-2350.

本网站所有内容来源注明为“梅斯医学”或“MedSci原创”的文字、图片和音视频资料,版权均属于梅斯医学所有。非经授权,任何媒体、网站或个人不得转载,授权转载时须注明来源为“梅斯医学”。其它来源的文章系转载文章,或“梅斯号”自媒体发布的文章,仅系出于传递更多信息之目的,本站仅负责审核内容合规,其内容不代表本站立场,本站不负责内容的准确性和版权。如果存在侵权、或不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。

在此留言

#生成对抗网络# #多模态医学影像#

21