JMIR:ChatGPT在临床决策中,准确率高达71.7%!

2024-01-07 MedSci原创 MedSci原创 发表于加利福尼亚

美国最大的非营利医疗机构之一,麻省布里格姆医院集团,发表了一份关于ChatGPT在临床医疗决策中应用的研究论文。麻省布里格姆医院由麻省总医院(Massachusetts General Hospita

美国最大的非营利医疗机构之一,麻省布里格姆医院集团,发表了一份关于ChatGPT在临床医疗决策中应用的研究论文。麻省布里格姆医院由麻省总医院(Massachusetts General Hospital)和布莱根妇女医院(Brigham and Women's Hospital)于1994年合并而成。

据该医院称,ChatGPT在诊断提出、推荐诊断检查、最终诊断以及护理管理决策等方面的准确率达到了71.7%,在整个临床决策过程中表现令人惊讶。尤其值得一提的是,与初步诊断相比,ChatGPT在最终诊断任务中展现出了最高的准确率,达到了76.9%。

此外,在所有医学专业领域中,ChatGPT在初级保健和急诊环境中均表现出色,可作为医疗助手,辅助主治医生加强决策、治疗和护理工作,其在医疗领域的潜力巨大。

评估方法

研究人员评估了ChatGPT 在解决医疗综合临床决策方面的准确性,比较了患者的年龄、性别和临床表现的敏锐度。

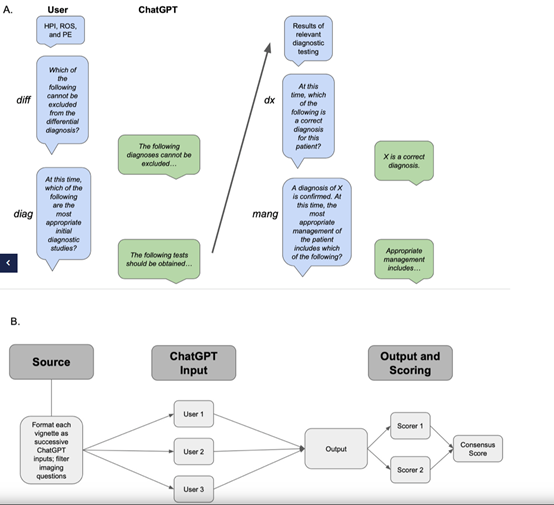

通过将临床工作流程的每一部分,作为对模型的连续提问,依次提出鉴别诊断、诊断测试、最终诊断和临床管理。

数据来源和测试

测试数据选自《默克手册》,这世界上最古老和最广泛使用的医学参考书之一,涵盖了各种疾病和医疗状况的详细信息,包括症状、病因、诊断、治疗和预防等内容。

例如,现病史 (HPI)、系统审查 (ROS)、体检(PE) 和实验室测试结果等,以模拟鉴别诊断、诊断检查和临床管理中的决策。

病例记录是通过将《默克手册》插图直接复制到 ChatGPT 中生成的。所有要求临床医生分析图像的问题都被排除在研究之外,因为ChatGPT 还无法准确识别医疗图片信息。

评分方法,ChatGPT每回答对一道题将获得1分,例如,每次 ChatGPT 的答案与提供的《默克手册》答案一致时都会获得一分。每一道题的最终分数计算为 3 次重复分数的平均值。

不同患者和年龄的表现

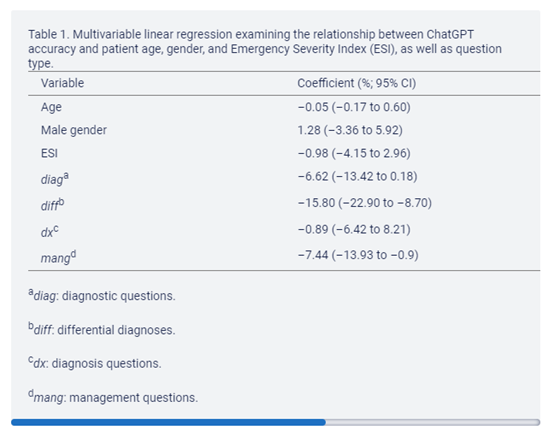

研究人员进行了多变量线性回归分析,以研究患者年龄和性别对ChatGPT 准确性的影响。年龄和性别的回归系数均不显着(年龄:P= 0.35;性别:P = 0.59;)。

这一结果表明,ChatGPT的表现在本研究中的各个年龄段,以及性别的二元定义中都是相同的。

测试结果:ChatGPT在所有36个临床测试题中的总体准确率达到71.7%;在做出最终诊断方面表现出最高的表现,准确率为76.9% ;在生成初级鉴别诊断方面表现最低,准确率为60.3%。

总体来说,ChatGPT在临床决策方面取得了令人印象深刻的准确性,并且随着它获得更多可用的临床信息将变得越来越强大。特别是,与初始诊断相比,ChatGPT在最终诊断任务中表现出最高的准确性。

在用药方面,ChatGPT可以提供正确用药但无法给出准确的剂量,这可能表明ChatGPT的训练数据偏向于语言准确性,而不是数字准确性。

如果想获得更准确的答案,可能需要对模型进行特定领域的数据训练和微调。

当然,研究也发现ChatGPT的局限性。首先,AI模型的推理能力不足,导致偶尔推荐无效治疗或即使拥有所有必要信息也拒绝提供诊断的情况。这些限制涉及误差类型,包括不一致性和虚构性。另一个局限性是研究所使用的内容是否与ChatGPT的训练数据集重叠,但对于研究的目的来说,这并不重要。

总的来说,AI在临床中的潜在价值,并提出了将其整合到电子健康记录中的可能性,以提高患者的治疗效果和工作效率。

原始出处:

Assessing the Utility of ChatGPT Throughout the Entire Clinical Workflow: Development and Usability Study.J Med Internet Res. 2023 Aug 22;25:e48659. doi: 10.2196/48659.

本网站所有内容来源注明为“梅斯医学”或“MedSci原创”的文字、图片和音视频资料,版权均属于梅斯医学所有。非经授权,任何媒体、网站或个人不得转载,授权转载时须注明来源为“梅斯医学”。其它来源的文章系转载文章,或“梅斯号”自媒体发布的文章,仅系出于传递更多信息之目的,本站仅负责审核内容合规,其内容不代表本站立场,本站不负责内容的准确性和版权。如果存在侵权、或不希望被转载的媒体或个人可与我们联系,我们将立即进行删除处理。

在此留言

#人工智能# #临床决策# #临床决策支持# #chatGPT#

28